Medientage in München

Vor einigen Wochen gingen die 30. Medientage München zu Ende. Das Kongressprogramm stand wenig überraschend in weiten Teilen unter der Fragestellung, was Big Data, Bots, Algorithmen und künstliche Intelligenz für Medienunternehmen und den Journalismus bedeuten. Am Ende bleibt der Eindruck, dass es ein bisschen zu viel um die KI-optimierte Auslieferung personalisierter Werbung ging, und ein bisschen zu wenig um die Frage, wie Algorithmen und künstliche Intelligenz den Qualitätsjournalismus von morgen beflügeln können, damit er weiterhin seine gesellschaftliche Relevanz behaupten kann. Am Bedarf dafür mangelt es nicht. Doch der Reihe nach.

Da war erst einmal die Eröffnungsrede von Angela Merkel. Sie äußerte sich bemerkenswert klar und, ja, in weiten Teilen auch bemerkenswert besorgt. Es war die Rede von einem „tiefgreifenden Umbruch nicht nur der Medienlandschaft, sondern auch der gesamten gesellschaftlichen Kommunikation“, und man könne „noch nicht richtig überblicken, was das alles für die gesellschaftlichen Verhältnisse in Deutschland, in Europa, auf der Welt bedeutet.“

Und dann baute sie eine Indizien-Kette auf, sprach davon, dass einem natürlich nicht alles gefallen kann, was man zu lesen, zu hören und zu sehen bekommt, dass aber gerade die Vielfalt der Medieninhalte und Meinungen eine freie Presse auszeichnet, diese Vielfalt aber immer mehr Leute immer weniger interessiere, dass es durch „digitale Technik“ ein Leichtes sei, sich in der eigenen Welt hermetisch abzuschotten…

Algorithmen und die „großen Plattformen“

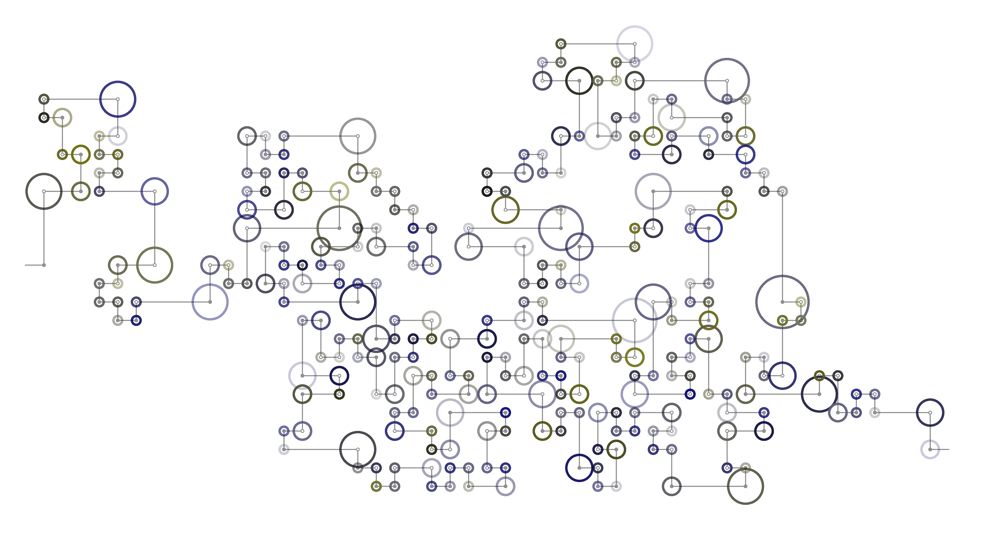

Im Fluchtpunkt ihrer Argumentation stand natürlich das böse A-Wort, es ging um Algorithmen und die „großen Plattformen“, die z.B. dazu führten, dass den Medienkonsumenten „gezielt und fast ausschließlich bestimmte Informationen angeboten werden – solche also, die an die bereits offenbarten Interessen der jeweiligen Internetnutzer oder an Empfehlungen und Kommentaren ihrer Internetfreunde anknüpfen.“ Ein solches Medienverhalten würde zur Verzerrung der Wahrnehmung führen und zu einem Blick auf die Welt, der weit von der Realität entfernt sein kann, mit Folgen für den gesellschaftlichen Diskurs. Da war sie wieder, die postfaktische Gesellschaft.

Besonders interessant war in diesem Zusammenhang dann Merkels Zuspruch für eine Feststellung von Klaus Schwab, Präsident des Weltwirtschaftsforums: Entscheidungsträger dieser Gesellschaft würden es verpassen, sich mit diesen „disruptiven Trends“ zu beschäftigen, sie seien nämlich in „traditionellen“ Denkmustern verhaftet. Das hört sich so an, als wäre da ein Groschen gefallen (wirklich der Richtige?), als wären ihr und den „traditionell“ denkenden Entscheidungsträgern in Davos plötzlich aufgefallen, dass mit dem „algorithmic turn“ mächtige neue Konkurrenz aufgezogen ist im Geschäft um die Gestaltung gesellschaftlicher Realitäten und Wahrnehmungen.

Wenn es so etwas wie Filterblasen und Echokammern gibt – wofür es noch keine empirischen Belege gibt – dann nicht erst seit der Popularisierung von Algorithmen. In der „traditionellen“ Welt analoger Entscheidungsträger waren und sind das z.B. die Hintergrund- und Kamingespräche.

Aus den Worten der Kanzlerin spricht die Erkenntnis, dass es plötzlich nicht mehr nur die politischen Eliten und klassischen Institutionen sind, die regulierend und strukturierend auf die Gesellschaft einwirken, sondern eben auch Algorithmen, die soziale Prozesse beeinflussen können, in dem sie Informationsflüsse und Aufmerksamkeitsressourcen lenken, Meinungs- und Willensbildung prägen, gesellschaftliche Kommunikation, Diskursräume und Öffentlichkeit strukturieren. Schließlich lassen sich Algorithmen konzeptionell, ihrer Wirkung und Funktion nach auch als Institutionen begreifen und beschreiben. Ja, selbst in der Intransparenz ihrer Wirkungsweise ähneln sie klassischen Institutionen.

Späte Erkenntnis

„Algorithmen gewinnen sozusagen eine gesamtgesellschaftliche Bedeutung“, so Merkel. Ist diese Erkenntnis tatsächlich jetzt erst angekommen in der Politik? Reichlich spät. Vielleicht fragt man sich in den Parteizentralen und Ministerien plötzlich, ob diese Algorithmen, Plattformen und Filterblasen etwas damit zu tun haben, dass der Hass seit kurzem näher rückt, als man es als Spitzenpolitiker und Amtsträger gewohnt ist, oder dass man sich mittlerweile freuen soll, wenn man auf öffentlichen Auftritten immerhin nicht ausgebuht wurde. Gegen die algorithmische Verzerrung und Filterblasen helfe, laut Merkel, nur ein Qualitätsjournalismus, der einordne und Einzelaussagen in Beziehung setze. Hieran schließt sich mein zweites Medientage-Takeaway an.

Natürlich ist es richtig, dass in dieser Gemengelage gerade auch eine Chance für den Journalismus liegt. Das wurde während des Vortrags von Armin Wolf so deutlich wie sonst leider nur noch selten in den weiteren Panels der Medientage. Gerade im „Zeitalter seiner digitalen Reproduzierbarkeit und Simulation“ sei es die Aufgabe des Qualitätsjournalismus, die Fakten wieder zurückzubringen in die „postfaktische Gesellschaft“, den Lesern Urteilsvermögen zu ermöglichen, Sinn von Unsinn zu unterscheiden, so Wolf. Journalisten „müssen Social Media-Plattformen hacken“ , „die algorithmus-produzierten Filterblasen aufstechen und die Newsfeeds mit ordentlichem Journalismus infiltrieren.“

Man hatte so eine Ahnung, was er da sagen wollte. Wolf fragte nach dem „Gegenangriff“, in der sich die alten journalistischen Tugenden mit den Mitteln der Digitalisierung verbünden, damit Journalismus auch weiterhin eine „Dienstleistung an der Gesellschaft“ erbringen kann. Und eigentlich waren diese Medientage ja auch der richtige Ort, um sich ernsthaft mit der Frage auseinanderzusetzen, wie die durch KI ausgelöste „zweite Welle der Digitalisierung“ (Wolfgang Wahlster, Deutsches Forschungszentrums für Künstliche Intelligenz) dabei helfen kann, dass Medien auch weiterhin „so etwas wie die Infrastruktur einer Demokratie“ (Armin Wolf) bleiben, und dass der Qualitätsjournalismus Bestandteil und Nutznießer der zukünftigen öffentlichen Dateninfrastruktur und Informationssphäre wird.

Möglichkeiten der Monetarisierung

Auffällig am weiteren Kongressprogramm war jedoch, dass eher nach Möglichkeiten der Monetarisierung gefragt wurde, nach dem Innovationspotential für „Content Marketing“ und „Programmatic Advertising“, und weniger danach, wie diese „zweite Welle der Digitalisierung“ trotz Rationalisierungsdruck zur Realisierung der von Wolf beschworenen journalistischen Tugenden beitragen kann (zu den vielen entsprechenden Panels über KI und Marketing musste man zumindest früh kommen oder im Gang stehen).

Wie können Big Data, Algorithmen, künstliche Intelligenz, kognitive Systeme und semantische Verfahren dabei helfen, noch umfassender und präziser zu recherchieren, die Story in den Bergen unstrukturierter Daten zu erkennen, zu kontextualisieren, zu verifizieren und zu falsifizieren, noch mehr Themen abzudecken, noch mehr Sprachen zu bedienen und einem noch größeren Publikum zu ermöglichen, „qualifizierter am demokratischen Diskurs teilzunehmen“ (Armin Wolf)?

Diese inhaltliche Diskussion um das Innovationspotential für das journalistische Handwerk und dem gesellschaftlichen Mehrwert eines Computational Journalism kam zu kurz. Angesichts der massiven Glaubwürdigkeitskrise des Journalismus, der Rede von Echo-Kammern, von der postfaktischen Gesellschaft und Wutbürgern, die „dem Internet“ mehr trauen als als den Qualitätsmedien, hätte man diesen Fragen einen größeren Platz einräumen müssen. Es bringt jedoch auch nichts, wenn der Diskurs über die Bedeutung von Algorithmen in einer Mediengesellschaft durchweg moralisiert und rein normativ geführt wird, wenn Extrempositionen wie bedenkenloser Fortschrittsglaube oder die Überhöhung algorithmischer Macht bzw. die Fokussierung auf dominante Plattformen eine Debatte unmöglich machen. Ein differenzierter und disziplinenübergreifender Diskurs muss die (medien)ethischen Problemlagen und aber auch die Chancen und das Innovationspotential nüchtern benennen

1148 mal gelesen